我院杨万扣教授团队在人工智能国际顶刊TPAMI发表通用视觉定位最新研究成果

近日,东南大学南通海洋高等研究院杨万扣教授团队在通用视觉定位(Generalized Visual Grounding, GVG)领域取得重要突破,相关成果发表于人工智能国际顶级期刊《IEEE Transactions on Pattern Analysis and Machine Intelligence》(TPAMI)。该研究提出的实例感知联合学习框架,有效解决了传统方法在复杂场景下面临的实例混淆与跨模态对齐不精准等核心难题,为自动驾驶视觉交互、智能机器人环境理解与跨模态检索等技术实际落地提供了坚实的理论支撑。

一、主要内容

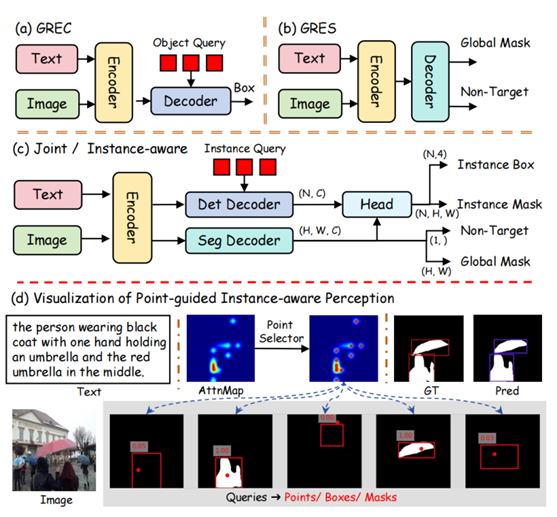

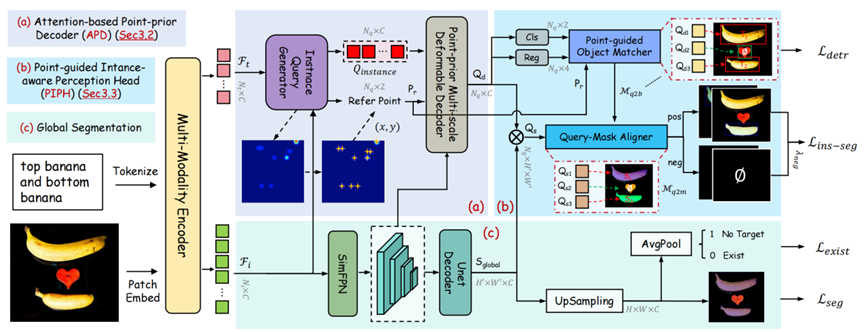

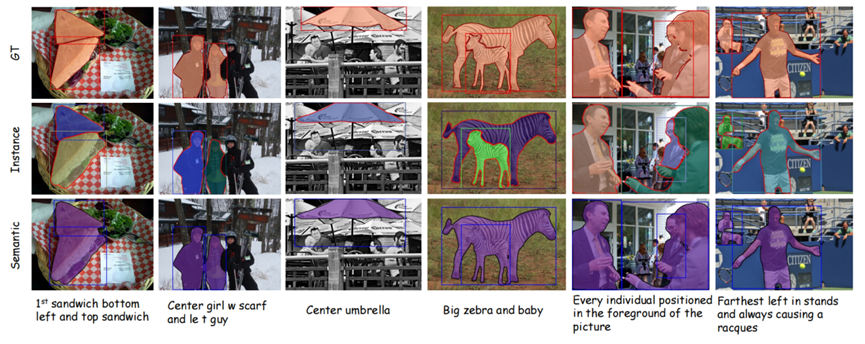

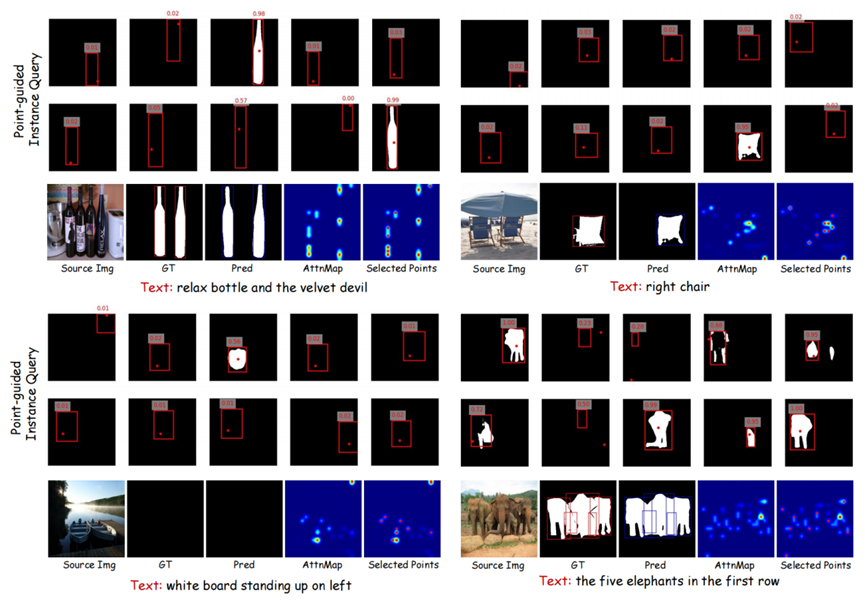

通用视觉定位是具身智能理解环境指令、机器人实现精准交互的基础能力。然而,现有方法在处理多目标、多粒度任务时,往往将粗粒度框选(GREC)与细粒度掩码分割(GRES)割裂对待,忽略了实例级框-掩码一致性与实例感知能力的关键作用。针对这一挑战,杨万扣团队的研究论文《Improving Generalized Visual Grounding with Instance-aware Joint Learning》(基于实例感知联合学习的通用视觉定位)创新地提出实例感知联合学习框架 InstanceVG。该框架通过为每个实例查询分配先验参考点,并在统一的查询-解码器结构中同时输出框与掩码,从而构建语言表达、目标框、目标掩码三者之间的跨粒度强关联。结合点优先参照、实例查询机制与联合训练策略,实现了 GREC 与 GRES 任务的协同优化,确保每个目标的框与掩码预测具有实例级一致性。该方法展现出优异的场景适应性与技术可扩展性。在多个国际公开数据集上的系统性实验表明,其综合性能显著超越现有主流方法。继NeurIPS 2024、AAAI 2025与ICCV 2025等顶级会议成果之后,本次研究在TPAMI期刊的发表,进一步彰显了团队在该方向的系统推进与国际影响力。论文第一作者为博士生戴铭,杨万扣教授为通讯作者,东南大学为第一作者及通讯作者单位。

中取得最佳性能.png)

中取得最佳性能.png)

中取得最佳性能.png)

代码链接: https://github.com/Dmmm1997/InstanceVG

论文链接:https://ieeexplore.ieee.org/document/11153716

本研究获得国家自然科学基金(项目编号:62276061、62436002)、东南大学南通海洋高等研究院科研基金重大项目(MP202404)资助,同时得到东南大学博士研究生创新能力提升计划(CXJH SEU 25125)的支持。